Microprocesador.

El microprocesador es un circuito integrado que contiene algunos o todos los elementos hardware, y el de CPU, que es un concepto lógico. Una CPU puede estar soportada por uno o varios microprocesadores, y un microprocesador puede soportar una o varias CPU. Un núcleo suele referirse a una porción del procesador que realiza todas las actividades de una CPU real.

La tendencia de los últimos años ha sido la de integrar más núcleos dentro de un mismo empaque, además de componentes como memorias Cache y controladores de memoria, elementos que antes estaban montados sobre la placa base como dispositivos individuales.

Funcionamiento.

Desde el punto de vista lógico, singular y funcional, el microprocesador está compuesto básicamente por: varios registros, una Unidad de control, una Unidad aritmético-lógica, y dependiendo del procesador, puede contener una unidad en coma flotante.

El microprocesador ejecuta instrucciones almacenadas como números binarios organizados secuencialmente en la memoria principal. La ejecución de las instrucciones se puede realizar en varias fases:

PreFetch, Pre lectura de la instrucción desde la memoria principal,

Fetch, envío de la instrucción al decodificador,

Decodificación de la instrucción, es decir, determinar qué instrucción es y por tanto qué se debe hacer,

Lectura de operandos (si los hay),

Ejecución, (Lanzamiento de las Máquinas de estado que llevan a cabo el procesamiento).

Escritura de los resultados en la memoria principal o en los registros.

Cada una de estas fases se realiza en uno o varios ciclos de CPU, dependiendo de la estructura del procesador, y concretamente de su grado de segmentación. La duración de estos ciclos viene determinada por la frecuencia de reloj, y nunca podrá ser inferior al tiempo requerido para realizar la tarea individual (realizada en un solo ciclo) de mayor coste temporal. El microprocesador se conecta a un circuito PLL, normalmente basado en un cristal de cuarzo capaz de generar pulsos a un ritmo constante, de modo que genera varios ciclos (o pulsos) en un segundo. Este reloj, en la actualidad, genera miles de MHz.

Rendimiento El rendimiento del procesador puede ser medido de distintas maneras, hasta hace pocos años se creía que la Frecuencia de relojera una medida precisa, pero ese mito ("mito de los megahertz") se ha visto desvirtuado por el hecho de que los procesadores no han requerido frecuencias más altas para aumentar su poder de cómputo.

Durante los últimos años esa frecuencia se ha mantenido en el rango de los

Medir el rendimiento con la frecuencia es válido únicamente entre procesadores con arquitecturas muy similares o iguales, de manera que su funcionamiento interno sea el mismo: en ese caso la frecuencia es un índice de comparación válido. Dentro de una familia de procesadores es común encontrar distintas opciones en cuanto a frecuencias de reloj, debido a que no todos los chip de silicio tienen los mismos límites de funcionamiento: son probados a distintas frecuencias, hasta que muestran signos de inestabilidad, entonces se clasifican de acuerdo al resultado de las pruebas.

La capacidad de un procesador depende fuertemente de los componentes restantes del sistema, sobre todo del chipset, de la memoria RAM y del software. Pero obviando esas características puede tenerse una medida aproximada del rendimiento de un procesador por medio de indicadores como la cantidad de operaciones de punto flotante por unidad de tiempo FLOPS, o la cantidad de instrucciones por unidad de tiempo MIPS. Una medida exacta del rendimiento de un procesador o de un sistema, es muy complicada debido a los múltiples factores involucrados en la computación de un problema, por lo general las pruebas no son concluyentes entre sistemas de la misma generación.

El proceso de fabricación de un microprocesador es muy complejo. Todo comienza con un buen puñado de arena (compuesta básicamente de silicio), con la que se fabrica un monocristal de unos 20 x

De este cristal, de cientos de kilos de peso, se cortan los extremos y la superficie exterior, de forma de obtener un cilindro perfecto. Luego, el cilindro se corta en obleas de menos de un milímetro de espesor (una capa de unas 10 micras de espesor, la décima parte del espesor de un cabello humano), utilizando una sierra de diamante. De cada cilindro se obtienen miles de obleas, y de cada oblea se fabricarán varios cientos de microprocesadores.

Estas obleas son pulidas hasta obtener una superficie perfectamente plana, pasan por un proceso llamado “annealing”, que consiste en someterlas a un calentamiento extremo para remover cualquier defecto o impureza que pueda haber llegado a esta instancia. Luego de una supervisión mediante láseres capaz de detectar imperfecciones menores a una milésima de micrón, se recubren con una capa aislante formada por óxido de silicio transferido mediante deposición de vapor.

De aquí en adelante, comienza el proceso del “dibujado” de los transistores que conformarán a cada microprocesador. A pesar de ser muy complejo y preciso, básicamente consiste en la “impresión” de sucesivas máscaras sobre la oblea, sucediéndose la deposición y eliminación de capas finísimas de materiales conductores, aislantes y semiconductores, endurecidas mediante luz ultravioleta y atacada por ácidos encargados de remover las zonas no cubiertas por la impresión. Salvando las escalas, se trata de un proceso comparable al visto para la fabricación de circuitos impresos. Después de cientos de pasos, entre los que se hallan la creación de sustrato, la oxidación, la litografía, el grabado, la implantación iónica y la deposición de capas; se llega a un complejo "bocadillo" que contiene todos los circuitos interconectados del microprocesador.

Un transistor construido en tecnología de 45 nanómetros tiene un ancho equivalente a unos 200 electrones. Eso da una idea de la precisión absoluta que se necesita al momento de aplicar cada una de las mascaras utilizadas durante la fabricación.

Los detalles de un microprocesador son tan pequeños y precisos que una única mota de polvo puede destruir todo un grupo de circuitos. Las salas empleadas para la fabricación de microprocesadores se denominan salas limpias, porque el aire de las mismas se somete a un filtrado exhaustivo y está prácticamente libre de polvo. Las salas limpias más puras de la actualidad se denominan de clase 1. La cifra indica el número máximo de partículas mayores de 0,12 micras que puede haber en un pie cúbico de aire (

Una vez que la oblea ha pasado por todo el proceso litográfico, tiene “grabados” en su superficie varios cientos de microprocesadores, cuya integridad es comprobada antes de cortarlos. Se trata de un proceso obviamente automatizado, y que termina con una oblea que tiene grabados algunas marcas en el lugar que se encuentra algún microprocesador defectuoso.

La mayoría de los errores se dan en los bordes de la oblea, dando como resultados chips capaces de funcionar a velocidades menores que los del centro de la oblea. Luego la oblea es cortada y cada chip individualizado. En esta etapa del proceso el microprocesador es una pequeña placa de unos pocos milímetros cuadrados, sin pines ni cápsula protectora.

Cada una de estas plaquitas será dotada de una cápsula protectora plástica (en algunos casos pueden ser cerámicas) y conectada a los cientos de pines metálicos que le permitirán interactuar con el mundo exterior. Cada una de estas conexiones se realiza utilizando delgadísimos alambres, generalmente de oro. De ser necesario, la cápsula es dotada de un pequeño disipador térmico de metal, que servirá para mejorar la transferencia de calor desde el interior del chip hacia el disipador principal. El resultado final es un microprocesador como el que equipa nuestro ordenador.

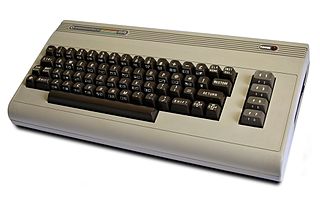

Microcomputadora.

Una microcomputadora es una computadora que tiene un microprocesador(unidad central de procesamiento).

Generalmente, el microprocesador tiene los circuitos de almacenamiento (o memoria caché) y entrada/salida en el mismo circuito integrado (o chip). El primer microprocesador comercial fue el Intel 4004, que salió el 15 de noviembre de 1971.

Desde el lanzamiento de la computadora personal de IBM, el IBM PC, el términocomputadora personal se aplica a las microcomputadora orientados a los consumidores. La primera generación de microcomputadora fue conocida también como computadoras domésticas. Se puede encontrar más información en las secciones correspondientes.

Fue el lanzamiento de la hoja de cálculo VisiCalc lo que hizo que los microcomputadoras dejasen de ser un pasatiempo para los aficionados de la informática para convertirse en una herramienta de trabajo.. Sus principales características son:

Velocidad de procesamiento: Decenas de millones de instrucciones por segundo.

Usuario a la vez: Uno (Por eso se llaman Personales).

Su uso mas comun es para propositos personales.

Tamaño: Pequeña, o portátiles.

Facilidad de uso: Supuestamente fáciles de usar.

Clientes usuales: Pequeñas empresas, oficinas, escuelas,

Penetración social: Mediana.

Impacto social: Alto, en los países industrializados.

Parque instalado: Cientos de millones en el mundo.

Costo: Pocos cientos de dólares estadounidenses.

Peso:

Supercomputadora.

Supercomputadora o Superordenador es un ordenador con capacidades muy superiores a las computadoras comúnmente disponibles al público general de la época en que fue construida.

Normalmente se utilizan en trabajos especializados que requieren un gran desempeño. Eso incluye medicina, ciencia, ingeniería avanzada, entre otros. Como ejemplo se encuentra la supercomputadoraRoadrunner; Ingenieros de IBM y del laboratorio de Los Álamos trabajaron seis años en la tecnología del ordenador. Algunos elementos de Roadrunner tienen como antecedentes videojuegos populares, de acuerdo con David Turek, vicepresidente del programa de superordenadores de IBM. En cierta forma, se trata de una versión superior de Sony PlayStation 3, indicó. "Tomamos el diseño básico del chip (de PlayStation) y mejoramos su capacidad", informó Turek.

Sin embargo, el superordenador Roadrunner difícilmente pueda asemejarse a un videojuego. El sistema de interconexión ocupa 557 m² de espacio. Cuenta con 91,7 km de fibra óptica y pesa 226,8 t . El Superordenador está en el laboratorio de investigaciones de IBM en Poughkeepsie, Nueva York y fue trasladada en julio del 2008 al Laboratorio Nacional Los Alamos, en Nuevo México.

Características.

Las principales son:

Velocidad de Proceso: miles de millones de instrucciones de coma flotante por segundo

Usuarios a la vez: hasta miles, en entorno de redes amplias

Tamaño: requieren instalaciones especiales y aire acondicionado industrial

Dificultad de uso: solo para especialistas

Clientes usuales: grandes centros de investigación

Penetración social: prácticamente nula.

Impacto social: muy importante en el ámbito de la investigación, ya que provee cálculos a alta velocidad de procesamiento, permitiendo, por ejemplo, calcular en secuencia el genoma humano, número Pi, desarrollar cálculos de problemas físicos dejando un margen de error muy bajo, etc.

Parques instalados: menos de un millar en todo el mundo

Costo: hasta decenas de millones de dólares cada una de ellas.